Aperçu de la réglementation concernant l’utilisation de l’intelligence artificielle dans le secteur des assurances

par David Sherwood et Emily Li

Gestion du risque, octobre 2023

L’intelligence artificielle (IA) et l’apprentissage automatique (AA) transforment rapidement le secteur des assurances. Ces technologies donnent aux assureurs l’occasion d’accroître leur efficience, de réduire leurs coûts et d’offrir un meilleur service à leur clientèle. Toutefois, l’IA/AA soulève également de nouveaux risques et fait face à des défis réglementaires.

Les gouvernements et les organismes de réglementation du monde entier s’affairent à élaborer des cadres régissant l’utilisation responsable de l’IA/AA dans le secteur des assurances. Ces cadres sont conçus pour protéger les consommateurs contre les biais et l’utilisation contraire à l’éthique de l’IA, tout en permettant aux assureurs d’utiliser ces technologies pour améliorer leurs processus. De façon générale, la réglementation actuelle comprend les domaines d’intérêt particuliers suivants :

- Protection des données : Les assureurs doivent faire en sorte de recueillir et d’utiliser les données de façon juste et transparente.

- Transparence algorithmique : Les assureurs doivent faire preuve de transparence sur la façon d’élaborer et d’utiliser les modèles d’IA/AA.

- L’atténuation des biais: Les assureurs doivent prendre des mesures pour atténuer le risque de biais dans les modèles d’IA/AA.

- Utilisation éthique : Les assureurs doivent utiliser l’IA/AA de manière éthique et responsable.

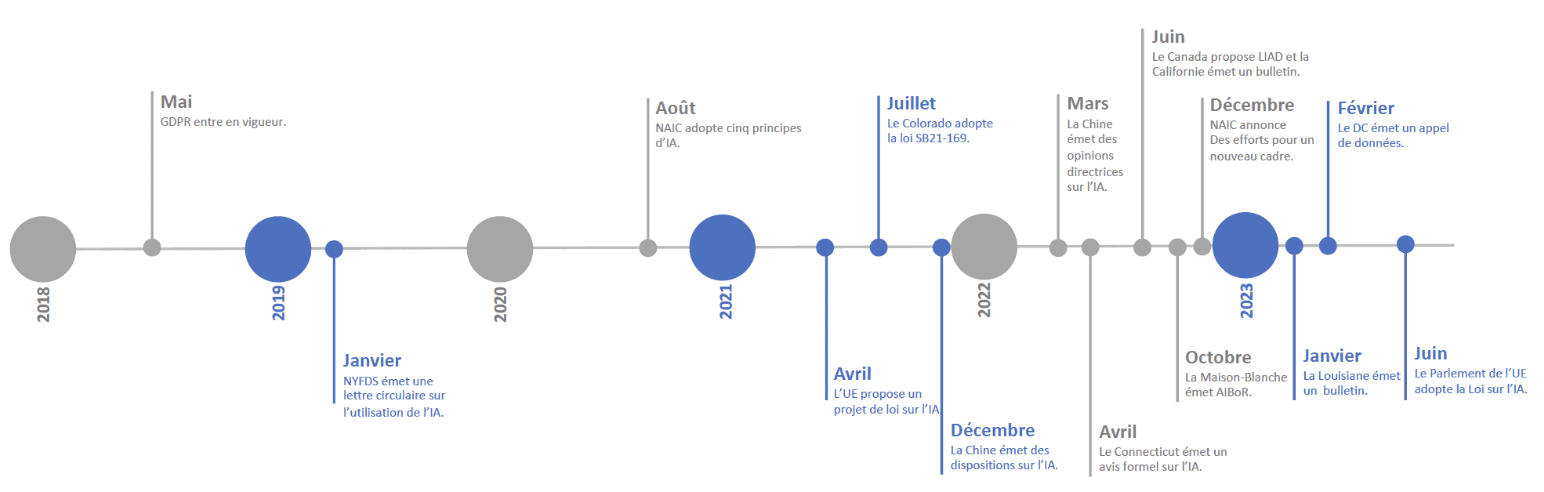

Le paysage réglementaire de l’IA/AA dans le secteur des assurances poursuit son évolution. Toutefois, il est évident qu’un plus grand nombre d’activités de réglementation se dérouleront au cours des prochaines années et qu’elles joueront un rôle important pour veiller à ce que l’utilisation de l’IA/AA profite aux clients et à l’industrie dans son ensemble. Le graphique 1 présente une chronologie de la réglementation de l’IA/AA qui montre un volume et une vélocité croissants de cette réglementation.

Graphique 1

Chronologie de la réglementation de l’IA/AA

La réglementation croissante appliquée à l’IA/AA signifie que les assureurs doivent connaître les exigences réglementaires qui régissent l’utilisation de ces technologies. Ils doivent également être prêts à démontrer qu’ils utilisent l’IA/AA de façon juste, transparente et éthique en améliorant le processus interne de gestion des risques et de gouvernance pour l’élaboration, la mise en œuvre, l’utilisation et la divulgation de ces outils.

Aperçu de la réglementation actuelle

États-Unis

Bien qu’il n’existe pas de réglementation sur l’IA/AA à l’échelle fédérale aux États-Unis, un certain nombre de règlements propres aux États et à des secteurs d’activité particuliers régissent la prestation de conseils relatifs à la réglementation sur l’utilisation des outils d’IA/AA.

NAIC

En août 2020, la National Association of Insurance Commissioners (NAIC) a publié les « Principles of Artificial Intelligence », qui brossent un tableau général de la réglementation de l’IA dans le secteur des assurances au moyen de cinq principes clés. Ceux-ci sont fondés sur les principes de l’IA de l’Organisation de coopération et de développement économiques (OCDE) qui ont été adoptés par 42 pays. Les cinq principes sont les suivants :

- Équité et éthique : Les acteurs dans le domaine de l’IA doivent respecter la primauté du droit tout au long du cycle de vie de l’IA. Ils doivent s’engager activement à gérer l’IA de manière responsable et digne de confiance dans le but d’obtenir des résultats bénéfiques pour les consommateurs et d’éviter la discrimination par procuration contre des groupes protégés.

- Responsabilité : Les acteurs de l’IA doivent faire preuve de responsabilité et veiller à ce que les systèmes d’IA fonctionnent conformément à ces principes, dans le respect de leurs rôles, dans le contexte approprié et en fonction de l’évolution des technologies. Les entreprises doivent appliquer un système de données appuyant les résultats ultimes de l’IA.

- Conformité : Les acteurs de l’IA doivent posséder les connaissances et les ressources nécessaires pour se conformer à toutes les lois et à tous les règlements applicables en matière d’assurance, que les infractions soient intentionnelles ou non.

- Transparence : Les acteurs de l’IA doivent être en mesure de protéger la confidentialité des algorithmes exclusifs et de démontrer le respect des lois et règlements des États où l’IA est déployée. Les organismes de réglementation et les consommateurs doivent être en mesure de s’informer sur les décisions d’assurance fondées sur l’intelligence artificielle, de les examiner et d’exercer des recours dans une présentation facile à comprendre.

- Sécurité/robustesse : Les systèmes d’IA doivent être robustes, sûrs et sécuritaires tout au long de leur cycle de vie dans des conditions d’utilisation normales ou raisonnablement prévisibles; les acteurs de l’IA doivent assurer un niveau raisonnable de traçabilité des ensembles de données, des processus et des décisions prises pendant le cycle de vie des systèmes d’IA.

Dans le cadre des principes susmentionnés, les acteurs de l’IA sont responsables de la création, de la mise en œuvre et de l’incidence de leurs modèles, et ils doivent veiller à ce que leur approche en matière de gestion des risques soit appliquée à chaque étape des processus de l’IA et respecte les lois et règlements existants.

À la fin de 2022, l’Innovation Cybersecurity and Technology (H) Committee a annoncé un projet visant à adopter un cadre réglementaire plus précis pour l’utilisation de l’IA. Ce cadre sera conçu pour lutter contre les préjugés et la discrimination dans les systèmes d’IA au moyen de directives générales fondées sur des principes.

En juillet 2023, le H Committee de la NAIC a publié un exposé‑sondage sur un bulletin type de l’utilisation de l’IA par les assureurs. Cette ébauche décrit les attentes des organismes de réglementation des assurances en matière d’utilisation et de gouvernance de l’IA. Elle est fondée sur des principes et elle encourage les assureurs, sans les obliger, à élaborer et à mettre en œuvre un programme écrit d’utilisation de l’IA, de modèles prédictifs et d’algorithmes, pour s’assurer que leur utilisation ne contrevient pas aux normes légales existantes, comme les lois sur les pratiques commerciales déloyales ou d’autres normes légales applicables. Elle ne crée pas de nouveaux règlements.

Les États

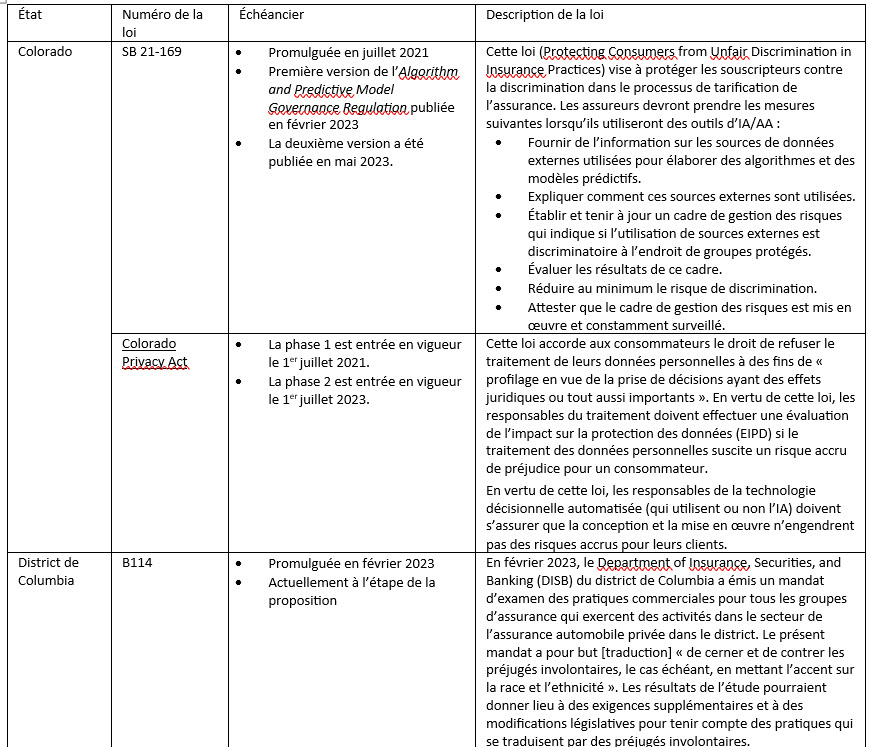

À ce jour, onze États ont adopté des lois sur l’IA et huit autres ont proposé de telles lois sur l’IA. Le graphique 2 donne un aperçu de la situation de la législation par État.

2 : Évolution de la législation par État

No proposals = aucune proposition

Legislation passed = législation adoptée

Legislation proposed = législation proposée

Legislation failed = législation non adoptée

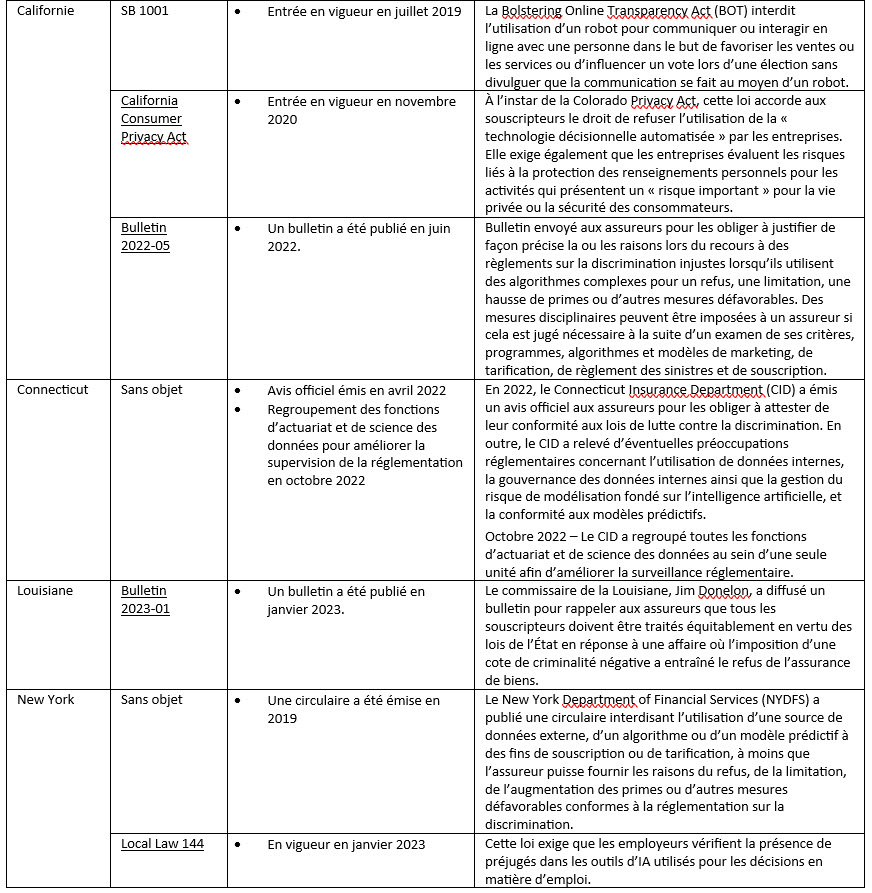

Le tableau qui suit énonce les lois qui ont été adoptées ou proposées dans les six États actifs au chapitre de la réglementation du recours à l’IA/AA.

La Maison-Blanche

Le Bureau des politiques scientifiques et technologiques (Office of Science and Technology Policy ou OSTP) de la Maison-Blanche a publié une Déclaration des droits relatifs à l’IA (AIBoR) en octobre 2022 afin de fournir des conseils aux organismes pour une utilisation éthique de l’IA. La Déclaration des droits contient cinq principes :

- Systèmes sûrs et efficaces : Se protéger contre l’utilisation inappropriée ou non pertinente des données en testant, en surveillant et en mobilisant les intervenants, les collectivités et les experts du domaine.

- Protections contre la discrimination algorithmique : Se protéger contre la discrimination en concevant équitablement des systèmes et en rendant les évaluations des systèmes compréhensibles et facilement accessibles.

- Confidentialité des données : Se protéger contre l’atteinte à la vie privée en limitant la collecte de données et en veillant à ce que les personnes conservent le contrôle de leurs données et de leur utilisation.

- Avis et explications : Fournir en temps opportun des explications claires des décisions ou mesures prises par un système automatisé.

- Alternance, examen et retrait : Offrir des occasions de se retirer des systèmes automatisés et d’avoir accès à des personnes qui peuvent remédier efficacement aux problèmes rencontrés dans le système.

De plus, le National Institute of Standards and Technology (NIST) a publié le document « AI Risk Management Framework » en janvier 2023 pour aider les organisations à gérer les risques associés à l’IA. Ce cadre décrit les principes d’une IA digne de confiance et qui sont conformes aux principes énoncés par l’OCDE. Il prévoit en outre quatre fonctions de base qui énoncent des mesures et des résultats précis pour gérer les risques liés à l’IA et mettre au point des systèmes d’IA fiables.

- Gouverner : Une culture de gestion du risque est mise en place et elle est présente.

- Mettre en contexte : Le contexte est reconnu et les risques connexes sont cernés.

- Mesurer : Les risques identifiés sont évalués, analysés ou suivis.

- Gérer : Les risques sont classés par ordre de priorité et des mesures sont prises en fonction de l’impact prévu.

Autres pays

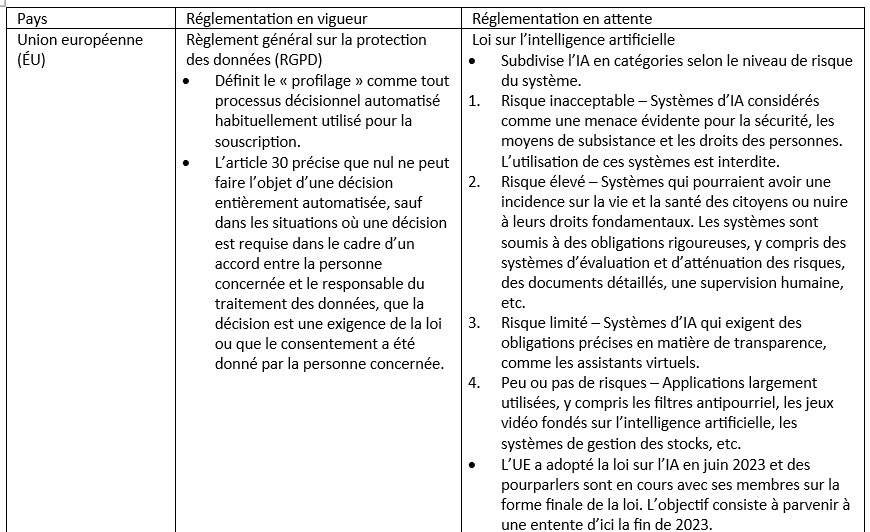

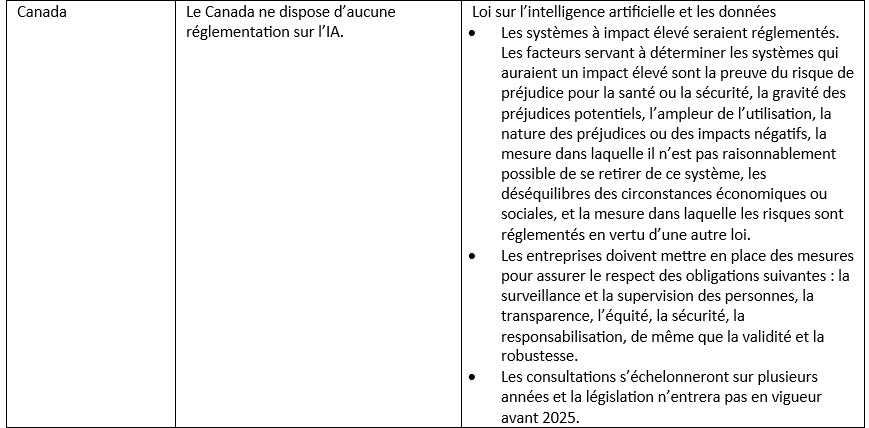

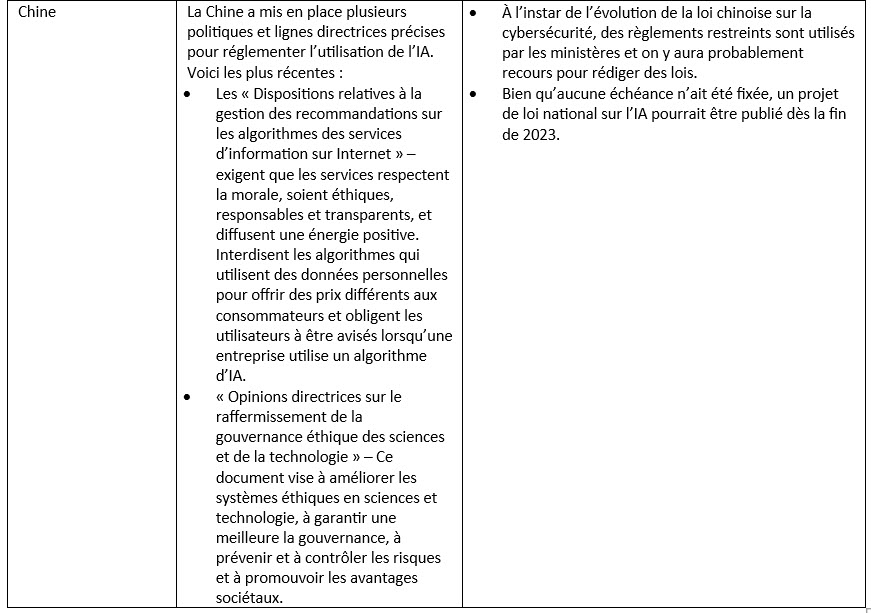

Outre les États-Unis, d’autres pays ont également pris des mesures pour atténuer les risques éventuels associés à l’IA dans le secteur des assurances. Certains pays s’appuient sur la réglementation existante, tandis que d’autres adoptent de nouveaux règlements sur l’IA. Ces pays comprennent ceux de l’Union européenne (UE), de même que le Canada et la Chine. Le tableau ci‑dessous décrit les règlements actuels et à venir dans ces pays.

Conclusion : C’est le moment de boucler votre ceinture

À mesure que croît l’utilisation de l’IA dans le secteur des assurances, le risque rattaché aux décisions fondées sur l’IA augmente. Bien qu’il n’existe pas encore de protocoles normalisés de gestion des risques et de mise à l’essai de l’IA, ce n’est qu’une question de temps avant qu’ils soient élaborés. Les assureurs doivent commencer à se préparer dès maintenant en mettant en œuvre une gouvernance et des cadres pour cerner, mesurer et gérer les risques liés à l’IA, comme les biais, l’opacité algorithmique, la vulnérabilité à la cybersécurité et le manque de responsabilisation. Les activités suivantes pourraient être mises à profit pour s’assurer que l’IA est utilisée de façon juste et éthique.

- Surveiller fréquemment les lois et principes d’orientation des organismes de réglementation.

- Former les employés sur les risques liés à l’IA et l’utilisation éthique de l’IA.

- Valider les outils d’IA avec un objectif approprié qui concilie les mesures de rendement du modèle, les mesures de rendement opérationnel et l’utilisation éthique de l’IA.

- Élaborer un système de surveillance continue pour tester les extrants de l’IA afin de détecter les biais éventuels provenant de diverses sources (p. ex., données, algorithme, interprétation).

- Être prêt à répondre aux plaintes des consommateurs concernant un éventuel parti pris.

- Améliorer l’interprétabilité et les explications de l’IA au moyen d’activités comme l’analyse exploratoire des données avant et ultérieures à la modélisation et aux techniques d’essai.

- Communiquer rapidement et clairement aux clients de l’information sur les décisions relatives à l’intelligence artificielle, et être prêt à répondre aux plaintes des consommateurs.

- Mettre en œuvre des politiques et des procédures pour s’assurer que tous les secteurs d’activité (p. ex., modélisateurs, utilisateurs opérationnels, TI, gestion des risques, conformité) respectent les principes directeurs de l’IA.

- Maintenir une surveillance et des communications efficaces avec les fournisseurs tiers.

Les faits énoncés et les opinions formulées dans le présent document sont ceux de chaque auteur et ne correspondent pas nécessairement à ceux de la Society of Actuaries, des rédacteurs du magazine ou des employeurs des auteurs respectifs.

David Sherwood est directeur général chez Deloitte. On peut le joindre à dsherwood@deloitte.com.

Emily Li, FSA, CERA, MAAA, est gestionnaire chez Deloitte. On peut la joindre à mengrli@deloitte.com.